Toda aventura conlleva sus riesgos. Curiosity sufrió el pasado miércoles el primer contratiempo serio de su misión, cuando se comprobó que el ordenador principal no estaba enviando los datos grabados a la Tierra. Tras analizar el estado del rover, el control de la misión determinó que ese día el ordenador no había entrado en modo de suspensión durante la noche como estaba previsto debido a una posición de memoria corrupta.

En cualquier otra misión, este fallo del ordenador principal habría supuesto un auténtico drama, pero por suerte Curiosity va equipado con dos ordenadores principales completamente redundantes, precisamente para evitar problemas de este tipo. Como resultado, el jueves 28 de febrero el control de tierra dio la orden de cambiar de ordenador, del «sistema A» al «sistema B». Durante el cambio de sistemas está previsto que el rover entre en modo seguro, por lo que se deben suspender todas las operaciones científicas. Desde el pasado jueves, el control de tierra está activando los sistemas de la sonda para devolverlos a su estado operativo, un proceso que lleva varios días por motivos de seguridad. Ésta no es la primera vez que el ordenador B de Curiosity está al mando, ya que fue empleado para controlar la nave durante el viaje desde la Tierra hasta Marte.

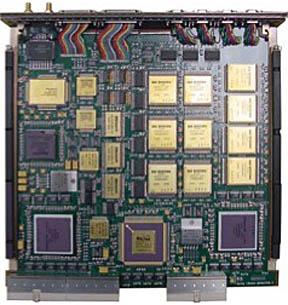

Los dos ordenadores de Curiosity pueden controlar todos los sistemas de la nave, aunque algunos -como las cámaras de navegación- poseen redundancias específicas para asegurar su funcionamiento con cualquiera de los dos. Por este motivo, el cambio al sistema B supone que Curiosity está usando ahora el par redundante de cámaras Navcams y los dos pares de Hazcams que todavía no habían sido estrenadas sobre la superficie de Marte. Cada ordenador, que funciona con el sistema operativo VxWorks, posee un procesador principal PowerPC 750 modificado para soportar altos niveles de radiación denominado RAD750. El procesador, construido por la empresa BAE Systems de Manassas (EEUU), funciona a un máximo de 200 MHz y posee 2 GB de memoria flash, 256 MB de memoria DRAM y 256 kB de memoria EEPROM. Es capaz de aguantar dosis de radiación un millón de veces superior a las consideradas peligrosas para un ser humano (1000 gray) y temperaturas de entre -55º y 70º C.

Dejando las redundancias a un lado, aún no está claro si estamos ante un fallo menor de la memoria o un problema serio (aunque por definición, cualquier suceso que cause la entrada en modo seguro de un vehículo es un grave inconveniente). La causa tampoco está clara, aunque todo apunta a la radiación, lo que no deja de ser paradójico. Curiosity puede funcionar sin problemas con un solo ordenador, pero si el sistema B también sufre algún contratiempo las cosas se pondrán mucho más feas. Y recordemos que estamos ante una misión que debe durar muchos años.

Antes de sufrir el fallo del ordenador, Curiosity ha continuado analizando las muestras obtenidas en la zona de Yelloknife Bay. El 30 de enero (Sol 173) usó el láser de la cámara ChemCam para analizar la roca Wernecke y el día 9 de febrero (sol 183) para investigar la composición del polvo del agujero que el taladro de Curiosity dejó sobre la roca John Klein.

El 20 de febrero (Sol 193), la cámara Mastcam realizó una fotografía del sistema de recogida de muestras para comprobar que el primer intento de recoger muestras había tenido éxito después de hacer pasar por el sistema CHIMRA el polvo obtenido tras taladrar la roca John Klein el 8 de febrero. En Sol 195 (22 de febrero) tuvo lugar un verdadero hito de la misión cuando CHIMRA, situado en el extremo del brazo robot, fue usado para enviar muestras al interior del instrumento CheMin. Un día después hizo lo propio con el instrumento SAM, también situado en el interior del rover. El fallo del ordenador principal ha retrasado el análisis de las muestras mediante estos instrumentos. En los próximos días, y mientras esperamos que se aclare la situación precisa en la que se encuentra el ordenador del sistema A de Curiosity, se recibirán los resultados de los primeros análisis de muestras por parte de CheMin y SAM.

Como es posible que los ordenadores tengan problemas de radiacion si Opportunity lleva tantos anios en la superficie con sistemas mas antiguos?

Saludos!

Nada tiene que ver que un sistema sea más o menos antiguo. El equipo de curiosity es más grande, complejo y por tanto más susceptible de verse afectado por la radiación, por ello lleva sistemas de protección más desarrollados que los de Opportunity, pero eso no quiere decir que no pueda verse afectado por esta. Para eso está la redundancia de ordenadores.

SpaceX vendería esto como un triunfazo… seguro…

También te digo una cosa como ingeniero informático. Hay mil motivos por los que puede corromperse una posición de memoria. Aventurarse a decir que ha sido la radiación o un rayo cósmico, a mi me parece un poco «Yo no he sido! lo juro! estaba así cuando llegué!!»

Aunque supongo que el equipo de técnicos sabrá bastante mejor que ha pasado y probablemente estén poniéndose en el peor escenario posible.

Es verdad Txemary, la memoria de un sistema puede corromperse por muchas causas mas «terrenales» que radiacion cosmica, y si no preguntenle a «Windows» las mil y una menera de corromper la memoria de nuestros ordenadores.

Hombre… doy por sentado que los ingenieros de la nasa habran descartado el fallo de software ejecutando sendos tests de memoria para finalmente determinar que se trata de un fallo de hardware.

Ahora que el fallo se deba a radiacion o no ya es mas complejo de determinar.

¿Que otra causa puede producir un fallo hardware en la ram? Defecto de fabricacion? Lo dudo muuuuuuucho. Fallo en la alimentacion? Lo registraria la telemteria.

Si los chips no han soportado la radiacion la cosa pinta muy mal porque los del ordenador B seran iguales. Creo recordar que los ordenadores redundantes del shuttle llevaban distintos chips para evitar situaciones asi, sera el curiosity similar? Alguien puede confirmarlo?

Hombre… doy por sentado que los ingenieros de la nasa habran descartado el fallo de software ejecutando sendos tests de memoria para finalmente determinar que se trata de un fallo de hardware.

Ahora que el fallo se deba a radiacion o no ya es mas complejo de determinar.

¿Que otra causa puede producir un fallo hardware en la ram? Defecto de fabricacion? Lo dudo muuuuuuucho. Fallo en la alimentacion? Lo registraria la telemteria.

Si los chips no han soportado la radiacion la cosa pinta muy mal porque los del ordenador B seran iguales. Creo recordar que los ordenadores redundantes del shuttle llevaban distintos chips para evitar situaciones asi, sera el curiosity similar? Alguien puede confirmarlo?

Salvo que sea un fallo de SW, jodidamente raro, es relativamente fácil descartarlo.

Y qué otra causa puede ser, hombre, cuando no se sabe a qué culpar siempre se dice… «será la estática» pero en el curiosity me parece que no cuela. Tendremos que esperar.

Ahora esto que ha pasado es perfectamente normal que ocurra, no es lo que esperas, pero si vas a Marte hay que estar preparado para solventar fallos importantes, de momento es solventable.

Y respecto a lo que comentas de la duplicidad, los ordenadores llevan el mismo procesador y las mismas características de memoria, pero no he encontrado referencia al tipo de chip.

Saludos

Por un momento pense que el culpable seria el sistema operativo llamado «ventanas» inventado por un señor apedillado «Puertas». Pero no usa otro, menos mal

Usa otro y hecho a medida para esto… no tendría sentido usar windows o una distribución desktop de linux…

EEUU y sus constantes fallas técnicas. Esto no es el país que fuera puntal en el 50-80.

Ahora cada dos misiones tres tienen problemas (por lo cual una directamente fue suspendida, y nos quedamos con dos misiones bugueadas).

El ordenador podría haberse puesto en una caja que lo aislase de la radiación (no tiene el «problema» de los humanos que necesitan salir de su caja protectora para salir a alimentarse, y bien podría estar en una caja sellada), junto a ser construido en materiales ultraresistentes. Y de paso con una redundancia en todo su diseño (dos buses de datos, dos memorias separadas, dos procesardores todo en el mismo computador). Pero la verdad es que entre los ahorros que llevan a usar «material de existencia en el mercado» junto a la tendencia en usar cosas ya obsoletas dentro de la electrónica (esa CPU era vieja cinco años antes de que el Curiosity despegara, y la justifican con que «es a prueba de radiación», psss… sí claro), le sumamos que cada vez q hay un error de diseño o ensamblaje, los yankees tienen la fea costumbre de taparlo todo y seguir como si nada. Si un ingeniero hace notar el fallo lo desoyen o lo despiden. Entre los problemas con el Shuttle, los problemas con el Hubble y los problemas con esta sonda alguno ya debería haber mejorado el «control de calidad». Pero ahí andan, la única solución es engordar el presupuesto y triplicar la redundancia (de subir la calidad ni se habla), y por ende al subir los costos suspender y cancelar otros proyectos porque «así ya no se puede» (con los nuevos parámetros de seguridad).

Ahí tenemos a SpaceX que ya tuvo DOS fallos en TRES misiones, y hacen un velo negro de todo para que nadie se entere de qué realmente pasó -no vayan a perder el currito.

Y no se sabe si es un «defecto sin importancia» (que no lo es) o un problema que amerita detener todos los futuros vuelos hasta rediseñar las cápsulas.

mmm discrepo, creo que estás un poco confundido, o igual no he pillado bien el tono de lo que dices.

1) Si fuese tan fácil proteger contra la radiación el ordenador… no lo hubiesen duplicado, lo hubiesen protegido. Y el diseño ya es totalmente redundante, al menos en lo que a memoria se refiere.

2) En lo de la CPU, lo siento pero no tienes razón. En un proyecto así una vez se decide un procesador y un conjunto de chips, estos no pueden cambiarse, habría que repetir un proceso de verificación costoso y muy lento. ¿Qué pasa? que esa elección se ha de hacer en una fase temprana del desarrollo, con lo cual hay que elegir un HW que haya pasado las pruebas de resistencia exigidas (sí ese control de calidad del que hablas), con lo que si ya es un sistema bastante viejuno al inicio del desarrollo, cuando el rover está en Marte pues parece un HW de hace siglos, pero si se quieren pasar los necesarios controles de calidad es lo que hay.

3) Salvo que estés haciendo una asevereción sobre los «yankees» en general, en cuyo caso ahí no me meto, no veo la relación entre los procesos de fabricación de SpaceX y la NASA, al menos a nivel de electrónica.

Saludos

Respecto al punto 3 puntualizo, no lo digo porque conozca los dos procesos, si no porque el de SpaceX no lo conoce nadie y no veo como se puede comparar… el de la NASA al menos, se explica en cada misión.

Francisco, no estoy de acuerdo en algunas de tus afirmaciones. ¿Dices que el RAD750 está obsoleto? Pues te animo a que encuentres uno mejor.

Por curiosidad, deciros que el RAD750 también lo lleva la MRO. Oppy y Spirit usan un RAD6000 (algo inferior), igual que Phoenix.

Saludos.

Te recuerdo que el ruso ni siquiera escapó de la tierra. Menos mal que es americano…bueno algo como Curiosity solo pueden hacerse en America!!!

La razón de usar procesadores tan «malos» es simple, a pesar de todo el blindaje antiradiacion es bastante probable que parte de esta lo atraviese y haga daños en el CPU.

Para evitar esto el CPU elegido funciona con casi 15 v de diferencia entre la posición 0 y la posición 1 (No corriente, corriente), esta diferencia logra que cuando reciba radiacion el circuito esta no cambie los datos, esto es diferente a los procesadores de computadoras que funcionan con una diferencia mucho menor y que permite hacer mas pequeños y poderosos los componentes.

La razón para usar procesadores con frecuencias pequeñas es que es menos probable que la radiación cambie el resultado de una operación logica si el tiempo permite que esta se estabilice y alcanze un «promedio» en el que la salida se mantenga el mayor porcentaje de tiempo posible en el dato correcto..

Super exagerado, veo tu msj muchos años después y creo que te callaron con sus acciones y resultados 😉

Sistema operativo VxWorks… Propietario. Los horribles routers Linksys de gama baja lo corren. Pffff!

Por qué no lo mandaron con Windows 98? Para un procesador de 200 Mhz y 256 Mb de RAM hubiera estado muy bien, y seguramente está más probado que VxWorks.

A veces la NASA me hace reír. Me cuesta entender cómo el depto de informática de la NASA (o como se llame) no tiene desarrollado un SO a medida de sus necesidades, estandarizado y recontraprobado en todas sus misiones. Seguramente sería mucho más fiable y barato que las decenas de combinaciones de OS/hardware que han usado a lo largo de los años. Me resulta extraña la idea de enviar una sonda a Marte con un SO diseñado para un aparato de consumo que ante un fallo el propietario procede a insultarlo y reiniciarlo, no necesariamente en ese orden. Pero bueno, sabemos que la NASA tiene otras consideraciones en su agenda además de la seguridad de sus misiones (humanas o robóticas).

La elección del VxWorks, sí que es un misterio para mi, supongo y espero (no he encontrado info al respecto) que tendrá alguna ventaja a la hora del desarrollo que desconozco o tienen un VxWorks propio o algo así. En sí el SO no es tan malo, otra cosa es que luego se le de el uso que se le da…

Creo que se deciden por VxWorks porque es un sistema operativo en tiempo real, muy importante para el procesado de multiples tareas criticas de un sistema. Utiliza kernel Unix y me parece que la Nasa lo utilitza desde hace tiempo en sus sondas, con lo que seguramente ya tienen su propia versión de S.O. depurada y conocida por todos los informaticos.

Primera ley de la informatica, si funciona no lo toques.

Hombre que es porque se necesita un SO en tiempo real está claro, pero he investigado un poco y hay centrales nucleares usando ese SO así que igual mi concepto de él era un poco parcial…

Los sistemas operativos en tiempo real se caracterizan por un mínimo tiempo de respuesta y una mayor fiabilidad, tolerancia a fallos y control del usuario. Generalmente estos sistemas, además, ocupan menos espacio y están optimizados para las tareas específicas que se requiere de ellos. Nadie instala un ordenador en una sonda espacial para jugar el The Witcher 2 con él.

Decir que vxworks es un mal sistema operativo porque una aplicación que lo usa falla, es simplemente no tener ni la mas mínima idea de lo que se dice.

¿VxWorks diseñado para un aparato de consumo? En serio, lee un poquito anda, asi dejaras de decir tonterias de semejante calibre.

Es un RTOS, esto es un robot, no una maquina para procesar texto, hacer hojas de calculo y jugar a WOW.

VxWorks es de lo mejorcito (si no el mejor) en RTOS hoy en dia en el mercado. Usado en todo tipo de aplicaciones que requieren tiempo real, aparatos de neuro-cirugia,etc.

Sobre el procesador de 250Mhz, lee un poco y entérate de porque la NASA emplea procesadores de este tipo antes de opinar semejantes cosas.

Estamos hablando de una gente que ha sido capaz de plantar un montón de hierros automatizados en Marte… digo yo…que ¿algo de informática sabrán no?

A ver si vamos a llegar ahora los listos que hemos reprogramado el firmware de un router a explicarle a la nasa que OS tiene que llevar el robot. Un poco de respeto por favor.

siempre, y digo siempre, que un sistema es operado en su ambiente de trabajo tendra problemas de diseño. Es una ley de diseño en la ingenieria.

ing. carlos parga

Claro, les hemos lanzado un escudo que ni el Capitan America, bombardeado con un monton de hierrajos y depositos llenos de hidrazina, les hemos pisoteado a conciencia, disparado mortiferos rayos laser y incluso agujereado con un taladro de bricomania … como no ivan los marcianos a defenderse contraatacando con sus rayos cosmicos?

#noshemospasado

Un saludo 😉

Ola!! Parece que lo «B» funciona en Marte, como la contabilidad de unos que yo me se ; )

Ahora en serio, hay que esperar que lo solucionen pero sobre todo llegar a saber si fueron la radiación o los rayos cósmicos los causantes de la avería porque de ser esta la causa da que pensar la fiabilidad de la protección que comentais. Y, en efecto, es muy pronto para fallos tan graves en una misión destinada a durar un mínimo de 2 años…Permanecemos atentos…

Yo creo que es un bug causado por la radiacion que ha corrompido datos o menos probable un fallo fisico de la memoria en alguna parte, por lo que formateando y marcando las celdas dañadas podria seguir sin problemas.

Por ejemplo los galaxy s3 tenian un bug del firmware de la memoria que les dañaba el chip y morian a los 6 meses aproximadamente,(leveling ) hasta que lo han solucionado con un parche en las ultimas actualizaciones.

Atlas

Yo creo que el RAD750 + WxWorks es lo mejor que se puede tener a un costo bajo (entiéndase bajo a escala de misión espacial). Tanto la arquitectura Power PC como el sistema operativo WxWorks son demostradamente sólidos y no dudo de que se habrá comprobado cada componente del RAD750 hasta donde se pudiera llegar.

Las cosas fallan simplemente porque no hay nada perfecto. A mi se me antoja que el almacenamiento flash (aunque el que hayan usado no tenga nada que ver con los pendrives que llevamos todos en un bolsillo) tiene problemas. Estará blindado contra radiación, pero la parte del almacenamiento siempre es la más frágil; no sé por qué, pero siempre es así.

Espero que puedan recuperarlo, porque se supone que la misión acaba de comenzar.

Es increible que Curiosity puede sobrevivir en Mars.